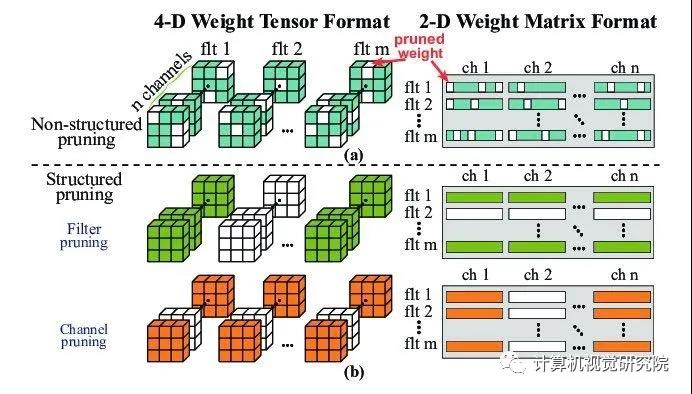

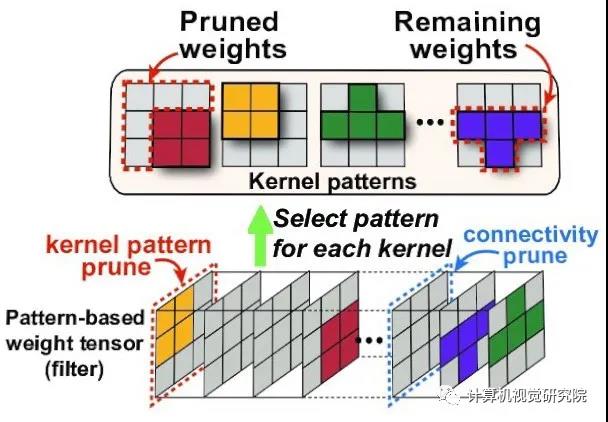

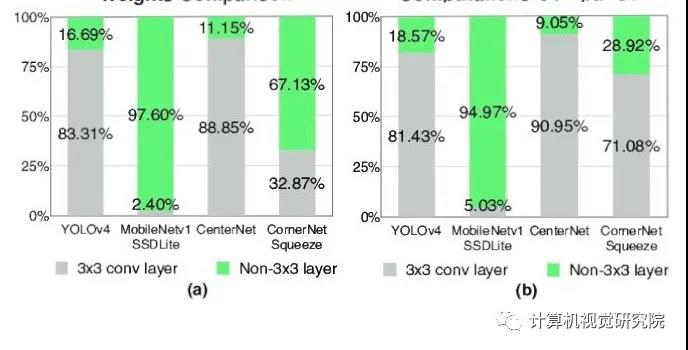

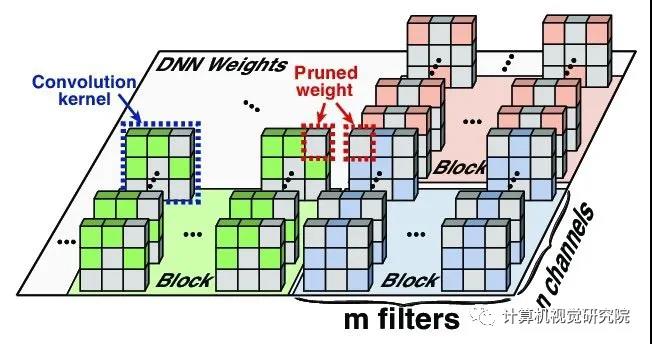

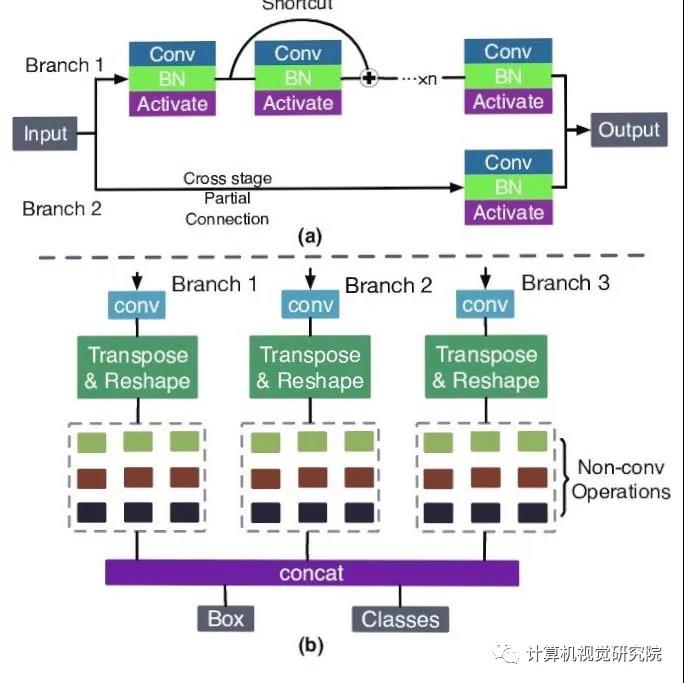

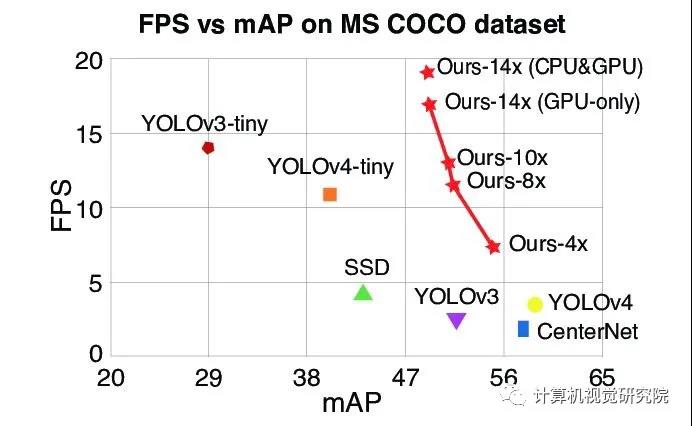

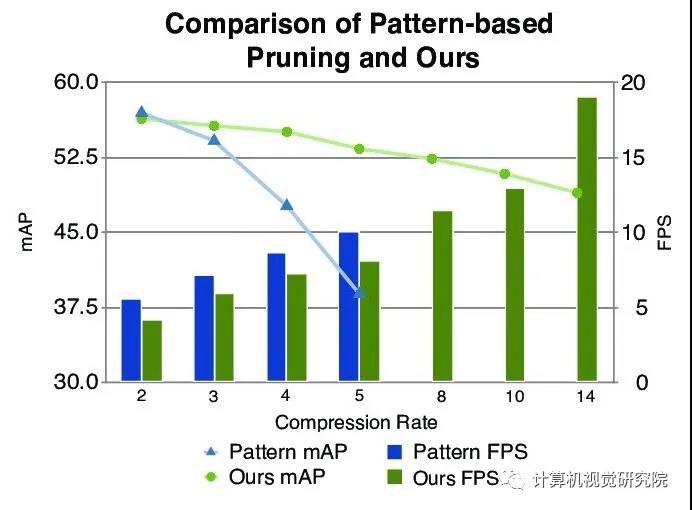

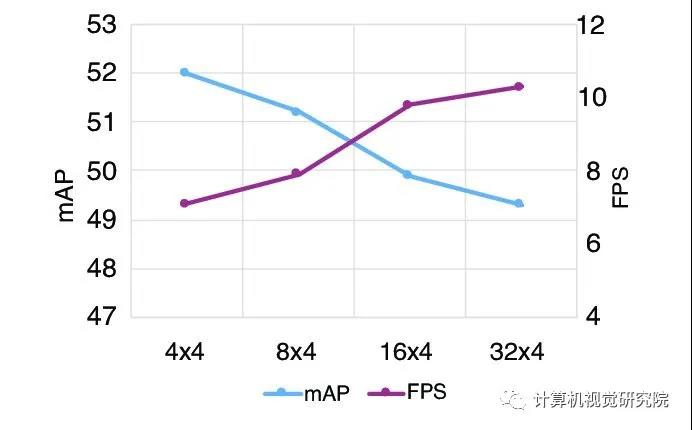

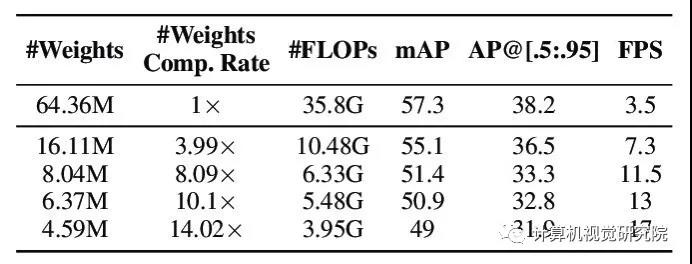

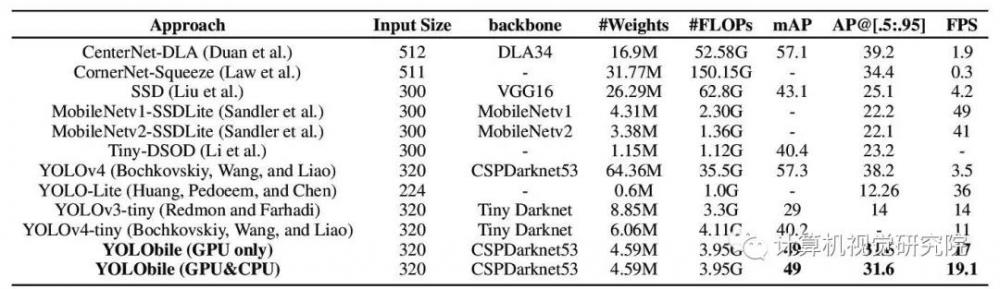

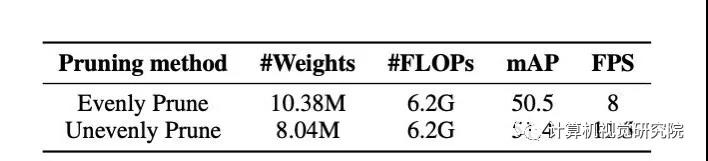

目标检测技术的迅速发展和广泛应用,引起了人们对目标检测器的精度和速度的关注。然而,目前最先进的目标检测工作要么是精度导向使用大模型,但导致高延迟,要么是速度导向使用轻量级模型,但牺牲精度。在这项工作中,作者提出了YOLObile框架,通过压缩编译协同设计在移动设备上实时检测对象。提出了一种适用于任意核大小的块穿孔剪枝方案。为提高移动设备上的计算效率,采用GPU-CPU协同方案,并辅以高级编译器辅助优化。实验结果表明,新提出的剪枝方案在49.0 mAP的情况下,可以实现YOLOv4的14倍压缩率。在YOLObile框架下,使用三星Galaxy S20的GPU实现了17 FPS的推理速度。通过加入新提出的GPU-CPU协同方案,推理速度提高到19.1帧/秒,比原来的YOLOv4加速5倍。

总结

在本次工作中,提出了一个基于压缩编译协同设计的移动设备实时目标检测框架YOLObile。此外,还提出了一种新的剪枝方案——区块剪枝,该方案适用于任意核大小的卷积层和全连接层。为了提高移动设备上DNNs的计算效率,除了新提出的编译器优化之外,提出的YOLObile还提供了一个GPU-CPU协同计算方案。经过实验证明,新提出的YOLObile框架展现出了高准确性、高效率,并同时实现了高硬件并行性!

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。